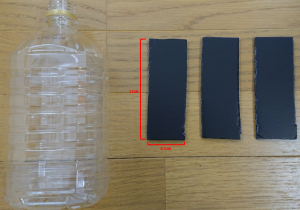

RaspberryPi zeroとヘッドセットをBluetooth接続します。今回は下記のヘッドセットをRaspberryPi zeroと接続します。

■Mpow 078 Bluetooth ヘッドセット(マイク付)

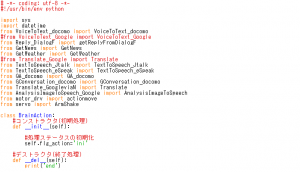

1)各種ライブラリのインストール

まずは、terminalを起動し、下記のコマンドを使って各種ライブラリをインストールしてください。

■Bluetoothのライブラリ sudo apt-get install pi-bluetooth

■bluemanをインストール、GUIにてペアリングを行うライブラリ sudo apt-get install blueman

■PluseAudioでBluetoothと内部機構を連携するライブラリ sudo apt install pulseaudio-module-bluetooth

■PulseAudio Volume Control (Pulse Audioを利用した音器量調整機能) sudo apt-get install pavucontrol

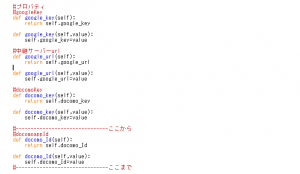

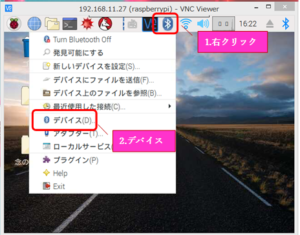

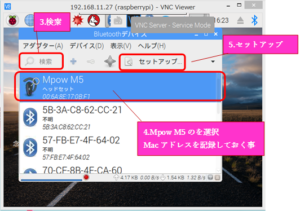

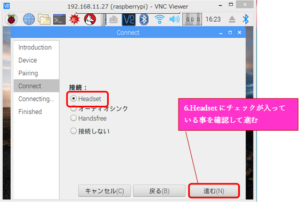

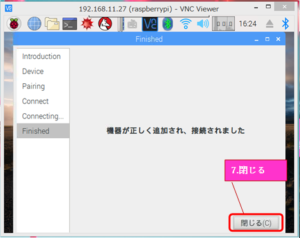

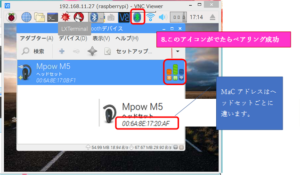

2)デバイスのペアリング

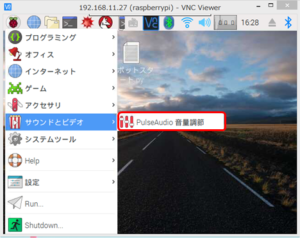

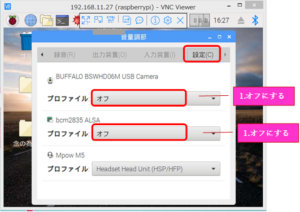

3)対象デバイスに対しての設定

ヘッドセット以外のマイク、スピーカーのデバイスをOFFにします。

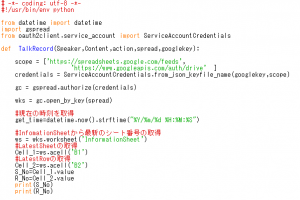

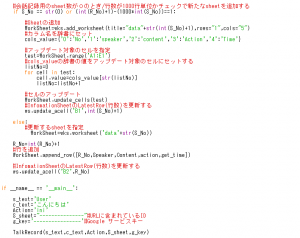

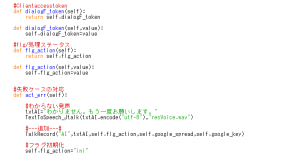

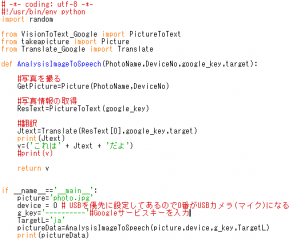

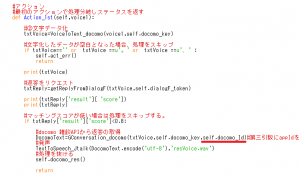

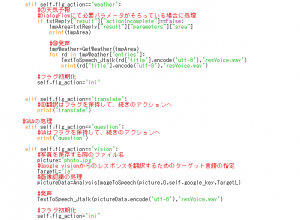

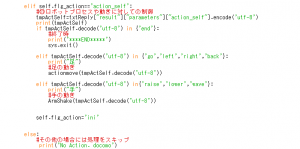

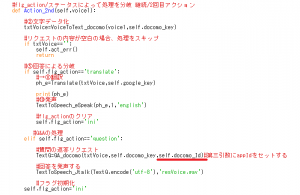

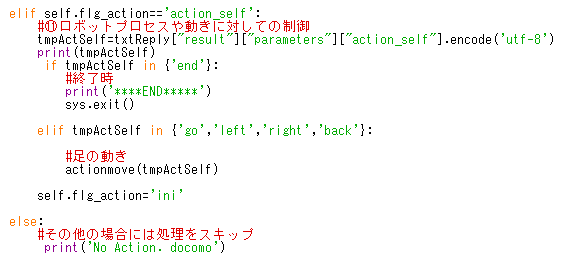

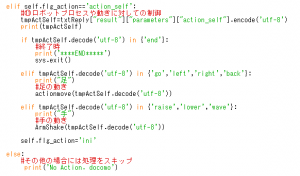

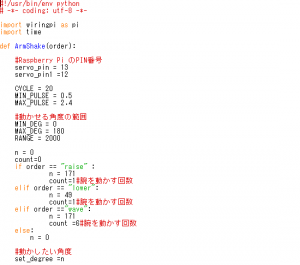

4)プログラムの修正

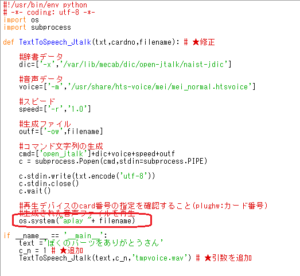

【TextToSpeech_Jtalk.py】

赤枠の「os.system(“aplay -D plughw:”+ str(cardno) + ” ” + filename)」から「os.system(“aplay “+ filename)」に修正します。

カード番号を指定する事でデバイスを選択してましたが、Bluetooth接続によってカード番号を指定しなくてもデフォルトがヘッドセットになります。

カード番号を指定したら今まで通りのデバイスが使用できます。

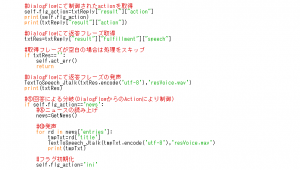

5)テストする

録音のコマンド、再生のコマンドを使ってヘッドセットのマイクで録音ができ、ヘッドセットのスピーカーで再生するか確認しましょう。

■録音のコマンド

arecord test.wav

■再生のコマンド

aplay test.wav